SecurityAI

Segurança da Informação & Inteligência Artificial

DeepSeek no seu Computador

Com o avanço da inteligência artificial, ferramentas como o DeepSeek estão se tornando cada vez mais acessíveis para diferentes aplicações. No entanto, muitos profissionais e entusiastas buscam alternativas para executar esses modelos de forma local, sem depender de serviços na nuvem.

Neste artigo, vou mostrar como utilizar o DeepSeek localmente através do Ollama, uma plataforma otimizada para rodar modelos de IA diretamente em sua máquina. Exploraremos o processo de instalação, configuração e os principais benefícios dessa abordagem, permitindo que você tenha mais controle, privacidade e eficiência ao trabalhar com IA generativa.

01 - Passo

Realize o Download e a instalação do Ollama

02 - Passo

Execute o comando ollama para exibir todas as opções:

PowerShellPS C:\> ollama

03 - Passo

Verifique se a porta 11434 está aberta:

PowerShellPS C:\> netstat -ano | findstr 11434

04 - Passo

Abra o navegador e acesse: http://localhost:11434 ou http://127.0.0.1:11434 para confirmar se o serviço do Ollama foi iniciado com sucesso:

05 - Passo

Liste os modelos disponíveis:

PowerShellPS C:\> ollama list

DeepSeek - Download do Modelo de IA

01 - Passo

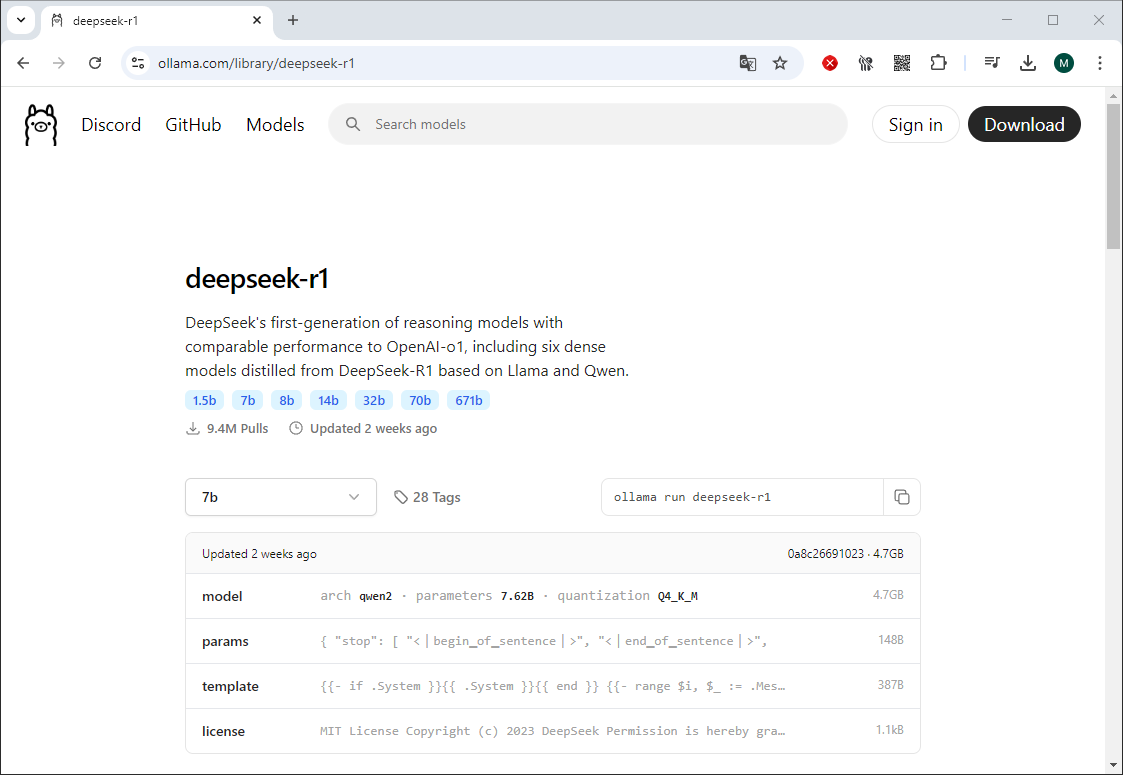

Para visualizar os modelos disponíveis acesse: ollama.com/library/deepseek-r1

02 - Passo

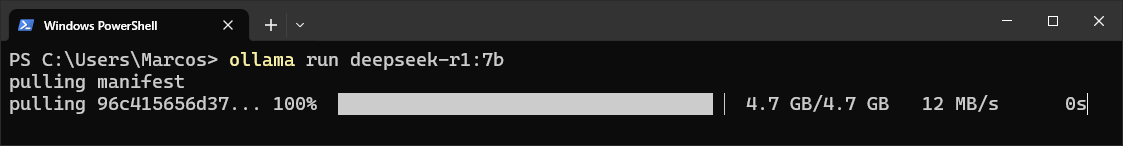

Realize o download do modelo deepseek-r1:7b

PowerShellPS C:\> ollama run deepseek-r1:7b

03 - Passo

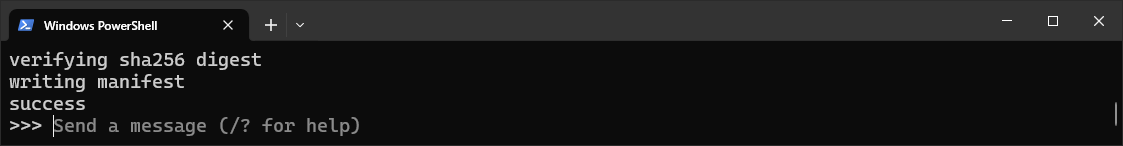

O modelo deepseek-r1:7b foi executado com sucesso e já pode ser utilizado.

PowerShell>>>

04 - Passo

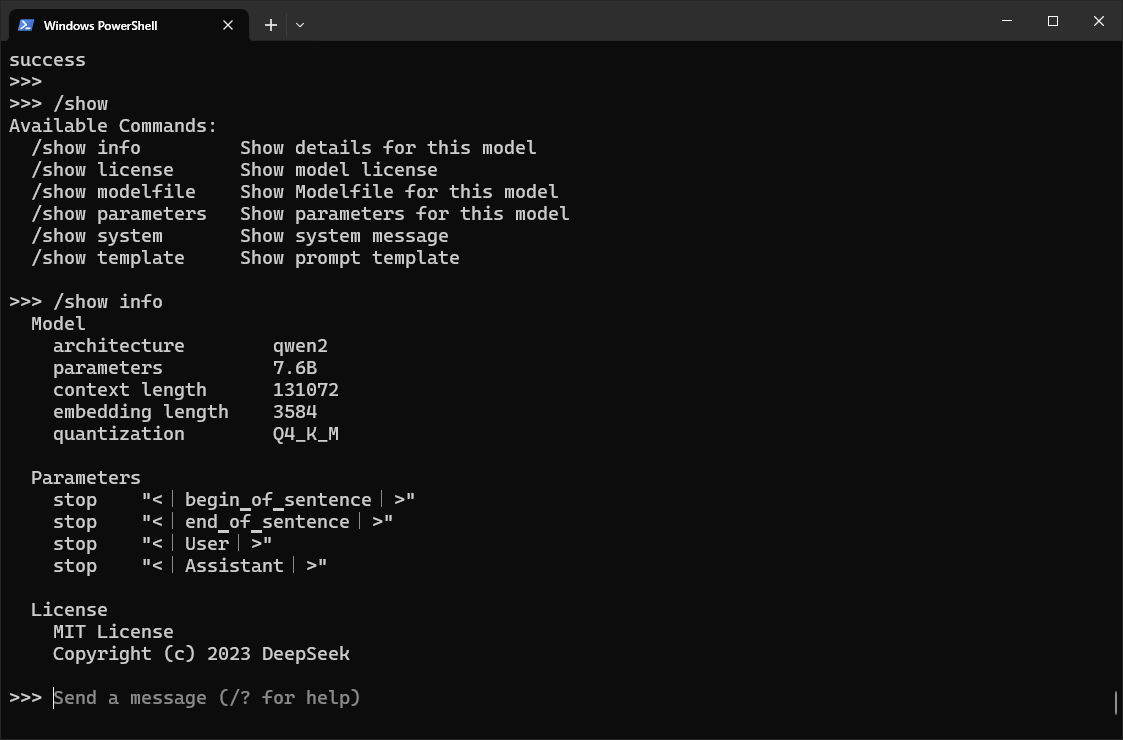

Utilize os parâmetros disponíveis para explorar o modelo, exemplo:

PowerShell>>> /show >>> /show info

05 - Passo

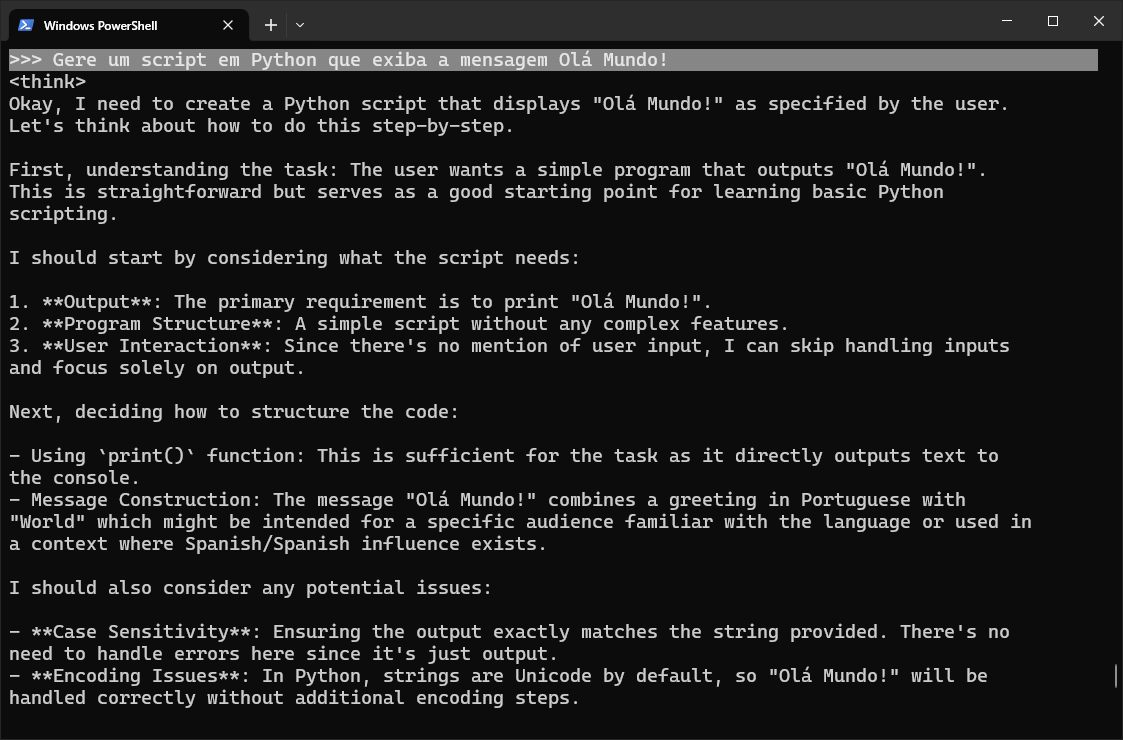

Agora basta interagir com o DeepSeek para obter as respostas.

Observe que entre as tags < thing > < / thing > o DeepSeek descreve como ele esta pensando para responder sua pergunta.

Pergunta:>>> Gere um script em Python que exiba a mensagem Olá Mundo!

06 - Passo

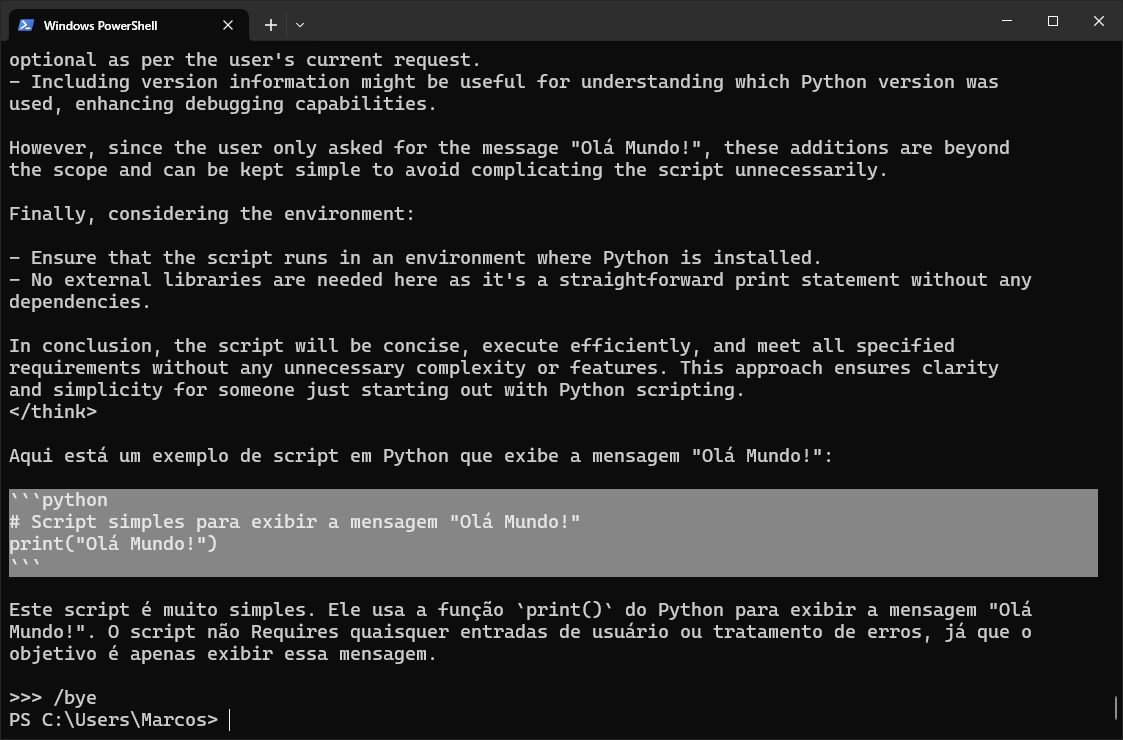

Aqui está a resposta, com o exemplo do script gerado!

Para sair do terminal digite: /bye

PowerShell

```python

# Script simples para exibir a mensagem "Olá Mundo!"

print("Olá Mundo!")

```

DeepSeek - Via Interface Web

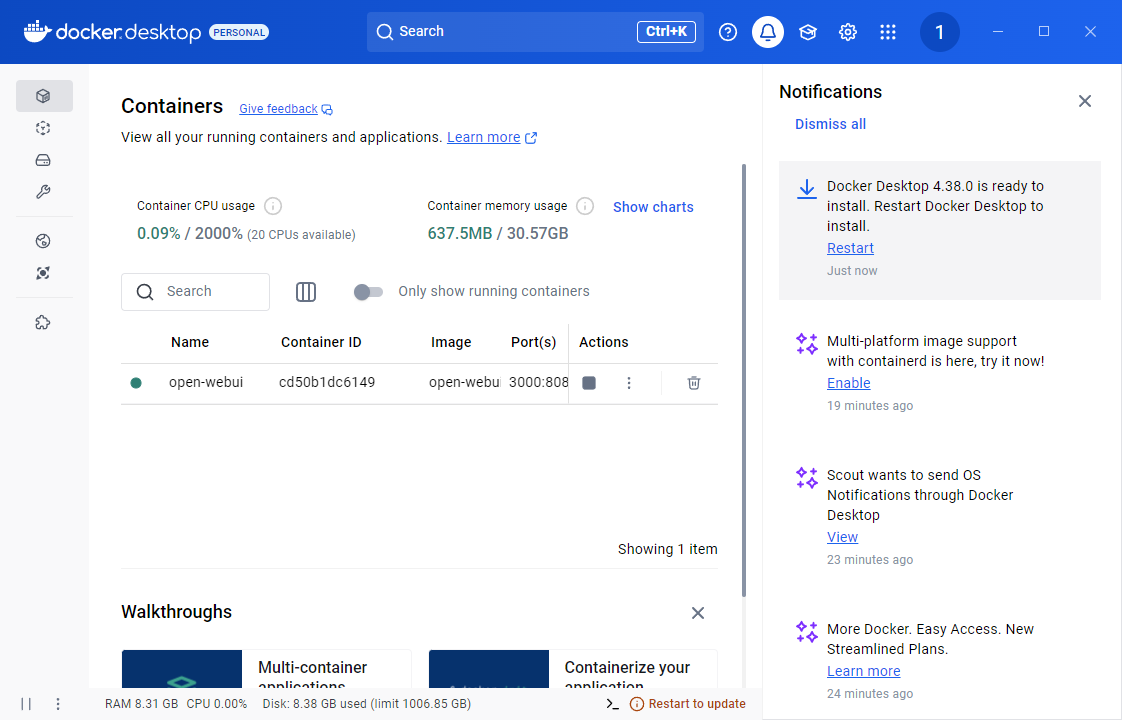

01 - Passo

Realize o download e a instalação do Docker Desktop.

02 - Passo

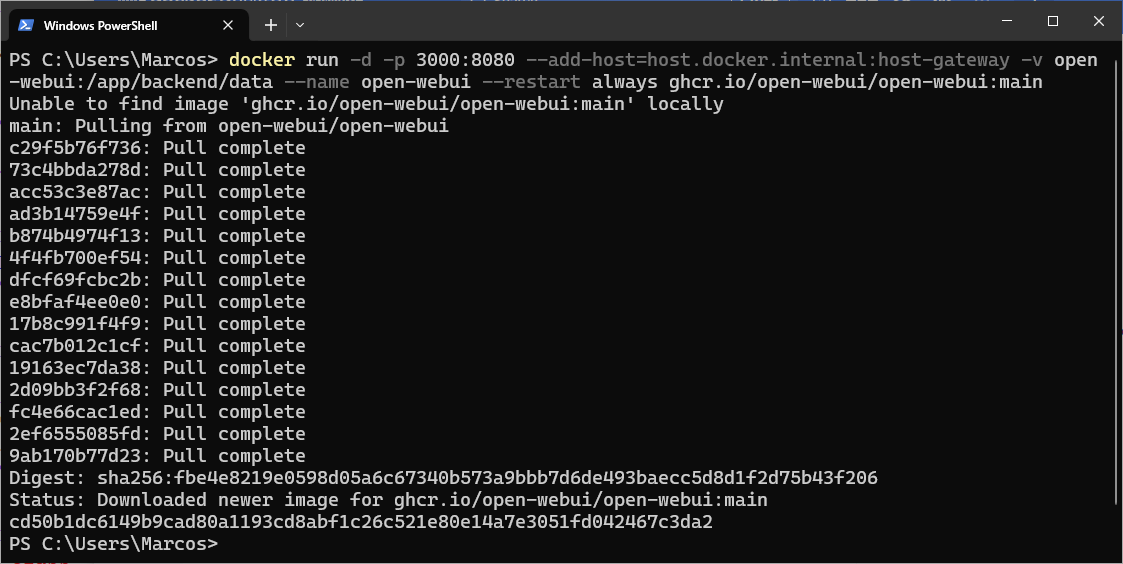

Execute um container Docker baseado na imagem do Open-WebUI.

PowerShelldocker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

03 - Passo

No menu Containers será exibido o open-webui, basta clicar no link disponível na coluna Port(s).

- http://localhost:3000

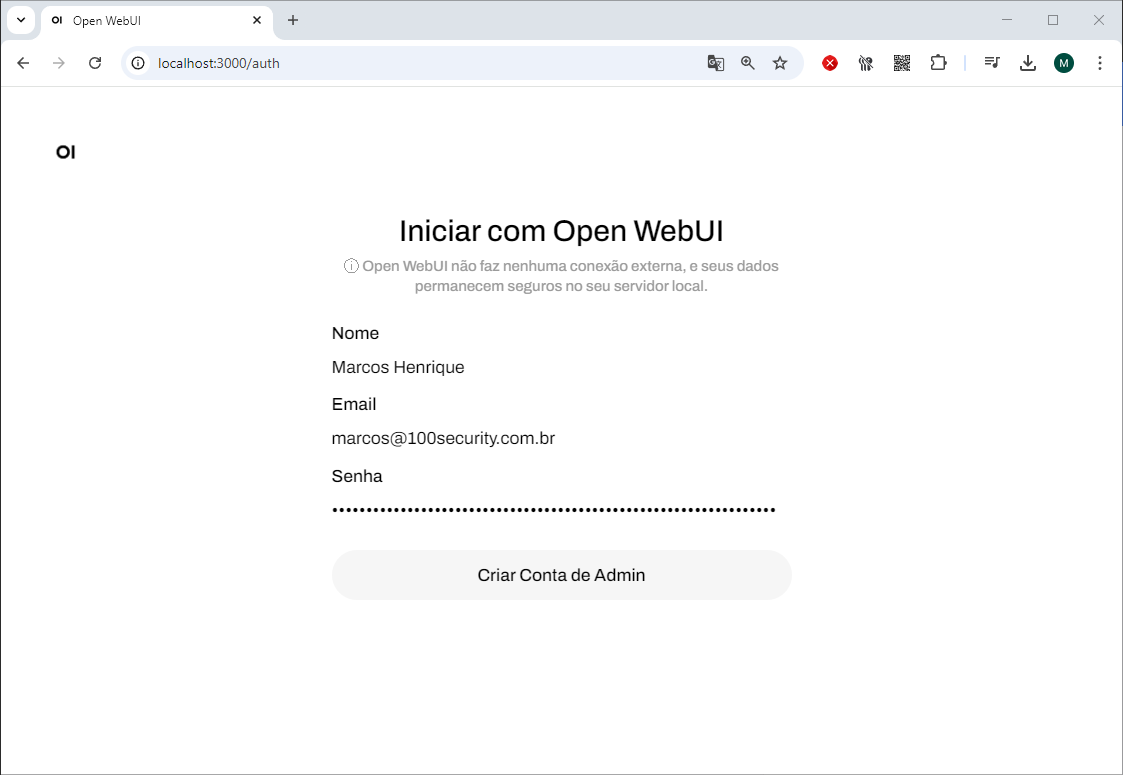

04 - Passo

Cria sua conta de Admin para realizar o acesso ao Open-WebUI

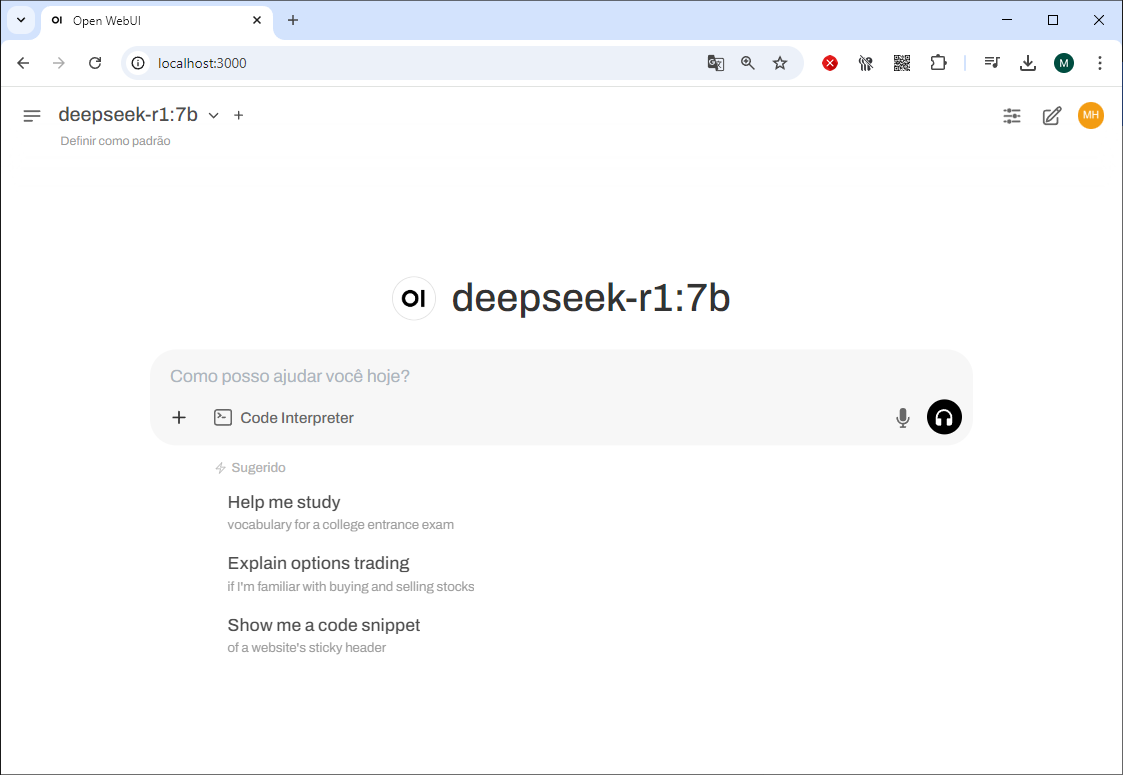

05 - Passo

Agora você pode explorar todo o potencial do DeepSeek 7B de forma local utilizando a Interface Web.

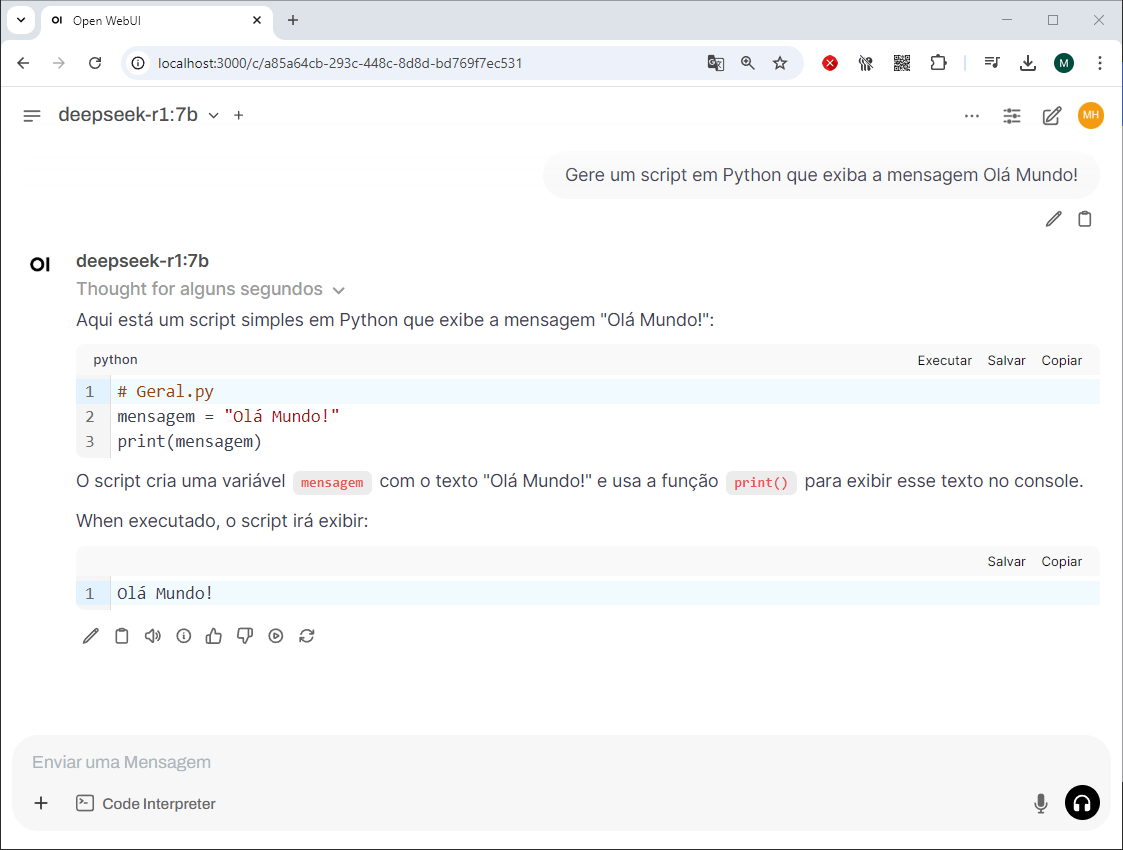

06 - Passo

Reproduzi o mesmo teste realizado via Terminal com a pergunta abaixo e este foi o resultado!

Gere um script em Python que exiba a mensagem Olá Mundo!

São Paulo/SP

São Paulo/SP